Код, статья, вёрстка и музыка: что уже может создать по описанию самый мощный алгоритм генерации текстов OpenAI GPT-3

Это ещё далеко не искусственный интеллект, но уже есть примеры работ, для которых почти не нужны люди.

В мае 2020 года лаборатория OpenAI представила алгоритм GPT-3. Он умеет по нескольким примерам выполнять множество заданий, прямо или косвенно связанных с текстом: писать стихи и новости, переводить, решать примеры, давать описания, разгадывать анаграммы, структурировать информацию и даже программировать.

Модель GPT-3 основана на той же архитектуре, что и предыдущая модель GPT-2, но в 116 раз сложнее: в ней используется 175 млрд параметров — вторая по мощности языковая модель Microsoft Turing-NLG содержит 17 млрд параметров, в GPT-2 1,5 млрд.

GPT-3 обучена на 570 ГБ текстовой информации, размер обученной модели — около 700 ГБ. В массив для обучения вошли данные открытой библиотеки Common Crawl, вся «Википедия», датасеты с книгами и полезные тексты с сайтов WebText.

В результате модель может писать тексты на английском языке практически неотличимые от человеческого уровня — по этой причине OpenAI не открывает полный доступ к модели, так как боится, что технологию можно использовать для дезинформации.

В июне OpenAI открыла частный доступ к инструментам для разработчиков (API) и модели GPT-3, представила собственные примеры использования алгоритма и запустила «игровую площадку».

Постепенно OpenAI подключает к GPT-3 всё больше разработчиков, которые демонстрируют возможности модели — и чем больше его изучают, тем масштабнее и интереснее возникают проекты.

Вот несколько примеров от OpenAI, энтузиастов и крупных компаний.

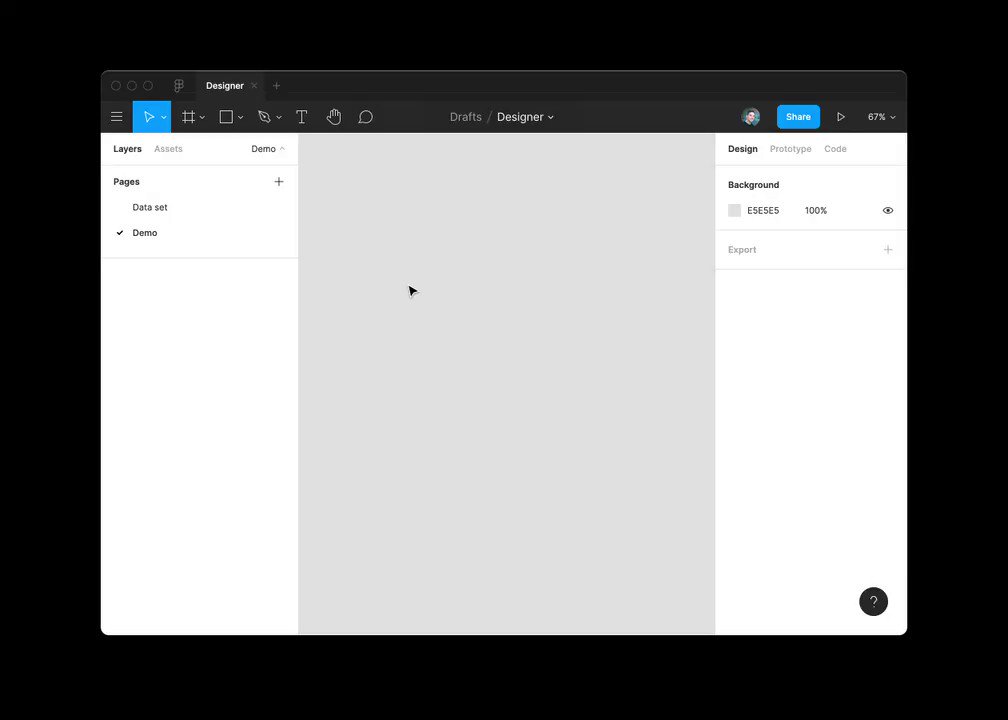

Вёрстка макета в Figma по описанию

Дизайнер Дордан Сингер разработал прототип плагина для Figma, который рисует макеты по текстовому описанию. Ему удалось обучить GPT-3 генерировать JSON-данные по текстовому описанию приложения и компонентов, а затем перевести их на макет Figma.

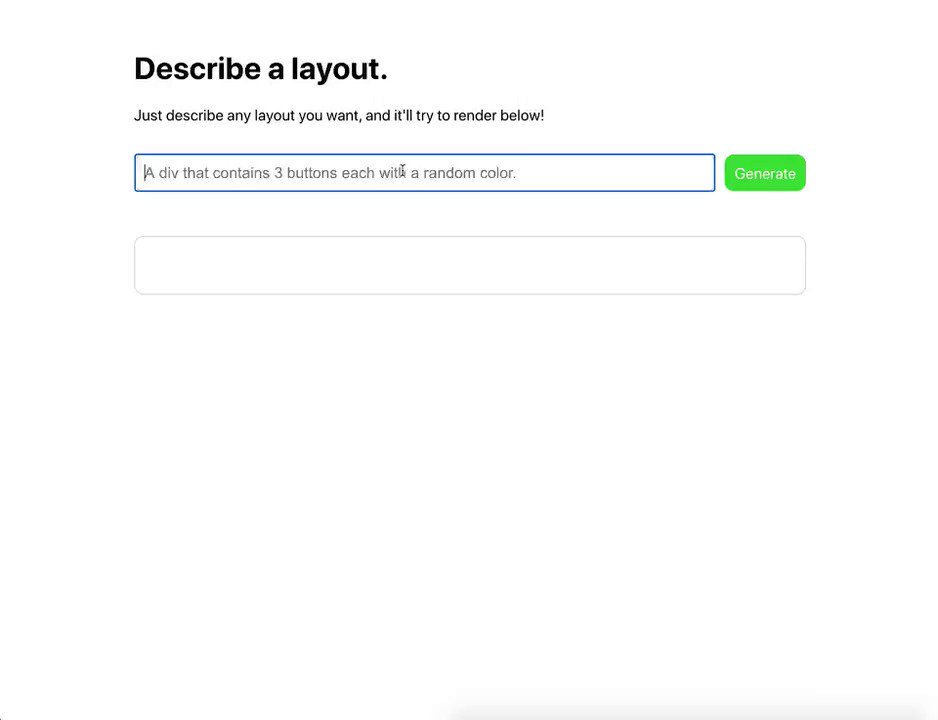

Вёрстка веб-компонентов по описанию

Разработчик Шариф Шамим по паре примеров кода и текстовому описанию научил GPT-3 создавать веб-элементы — достаточно написать алгоритму запрос вида: «зелёная кнопка и заголовок с текстом “Подписаться на рассылку”».

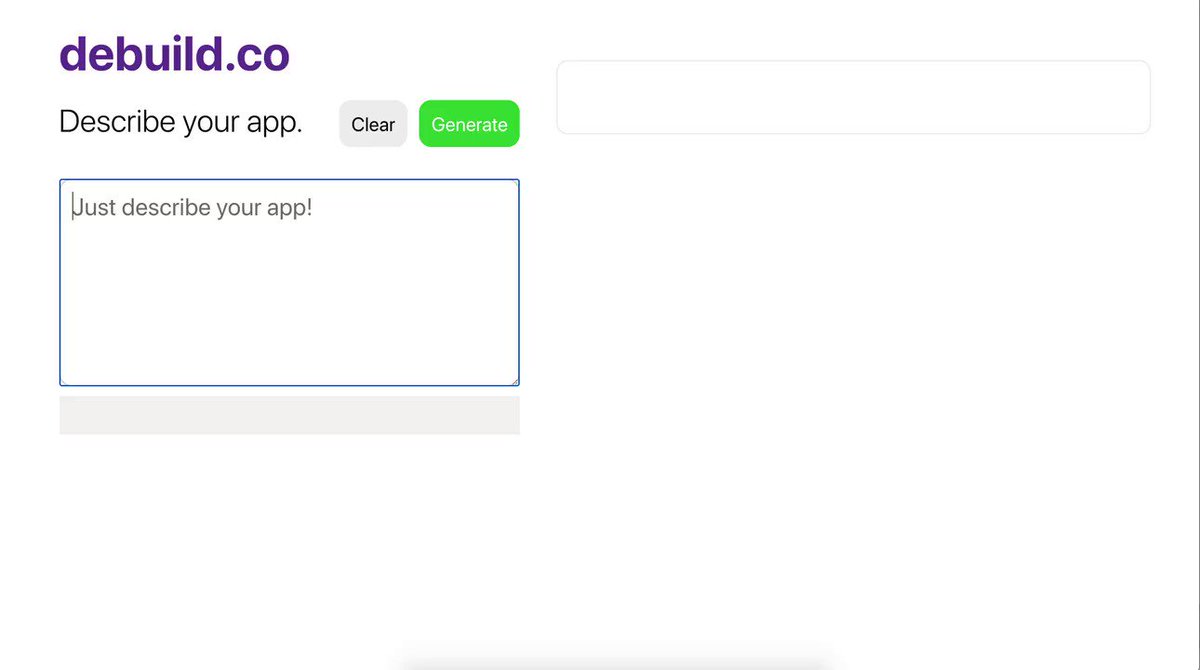

На базе GPT-3 Шамим запустил проект Debuild — это генератор React-приложений по текстовому запросу. Доступ к нему можно получить, заполнив Google-форму.

С помощью GPT-3 Шамиму удалось создать простой менеджер задач — его код алгоритм сгенерировал самостоятельно.

И простой калькулятор финансов:

Текстовая игра AI Dungeon генерирует продуманный мир без ограничений

AI Dungeon — бесплатная текстовая игра, в которой созданием мира, событиями и взаимодействием с игроком занимается искусственный интеллект на базе алгоритма Open AI GPT-2. Для работы AI Dungeon пользователю нужно вводить команды в текстовый блок, а игра реагирует на них, понимает контекст и адаптируется.

Создатели обновили её и перевели на GPT-3, что дало игрокам ещё больше возможностей. Теперь в игре нет ограничений: игрок вправе задать любую команду, на которую корректно отреагирует алгоритм и изменит игровой мир.

Игра может сгенерировать полноценную историческую и магическую системы, теории и правила, по которым работает мир, даёт персонажам воспоминания, а игроку — полную свободу действий, подстраиваясь под его действия и желания.

Создание списков по нужным данным

На примере GPT-3 генерирует список публичных ИТ-компаний по трём параметрам: название, тикер на бирже и год основания компании.

Ещё одна текстовая функция — разбор неструктурированных данных.

Поиск информации с запросом на естественном языке

Для работы GPT-3 достаточно открыть страницу в «Википедии» и задать вопрос по теме.

Автоматическая написание кода по комментариям

Microsoft и OpenAI показали пример автоматического написания кода на Python — программисту было достаточно написать комментарий на естественном языке с описанием задачи.

Модель была обучена на репозиториях GitHub и задействовала облачный суперкомпьютер Microsoft.

Генерация текстов любых форматов

По заявлению создателей, модель старается автоматически продолжить тексты в стиле пользователя, достаточно дать вводную и небольшой пример. Например, если дать GPT-3 половину сценария фильма или эссе, он допишет его. Энтузиасты также научили алгоритм генерировать бизнес-идеи.

Глава инвестиционной фирмы Founders Fund Делиан Аспарухов отправил GPT-3 половину записки для инвесторов о проекте Sword Health и получил несколько осмысленных абзацев, среди которых были разделы о рисках и долгосрочной стратегии развития стартапа.

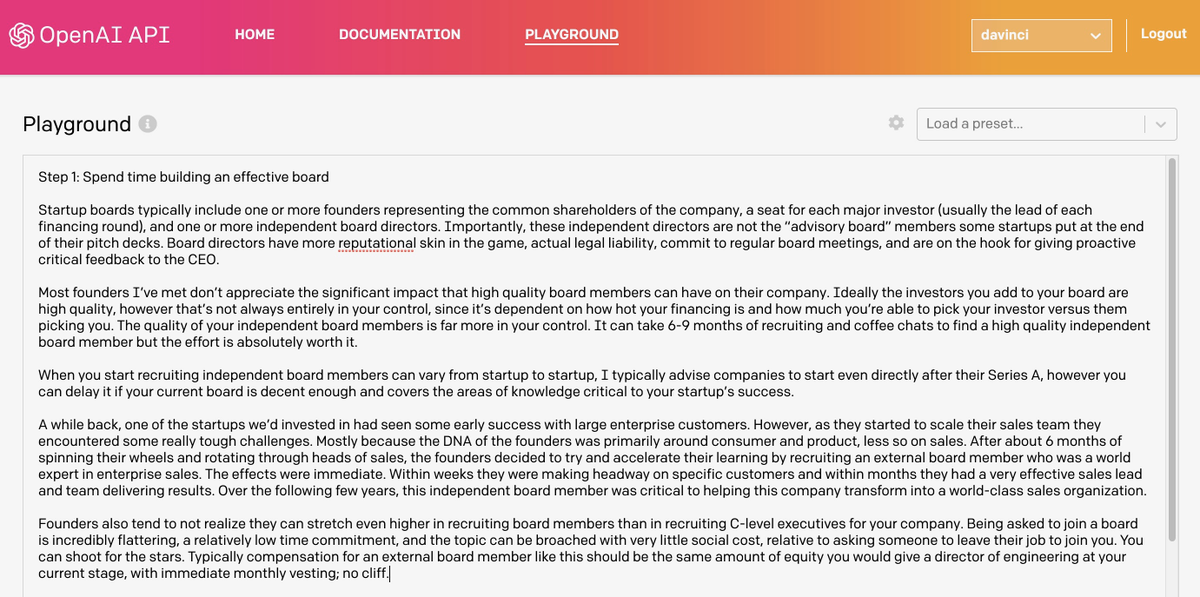

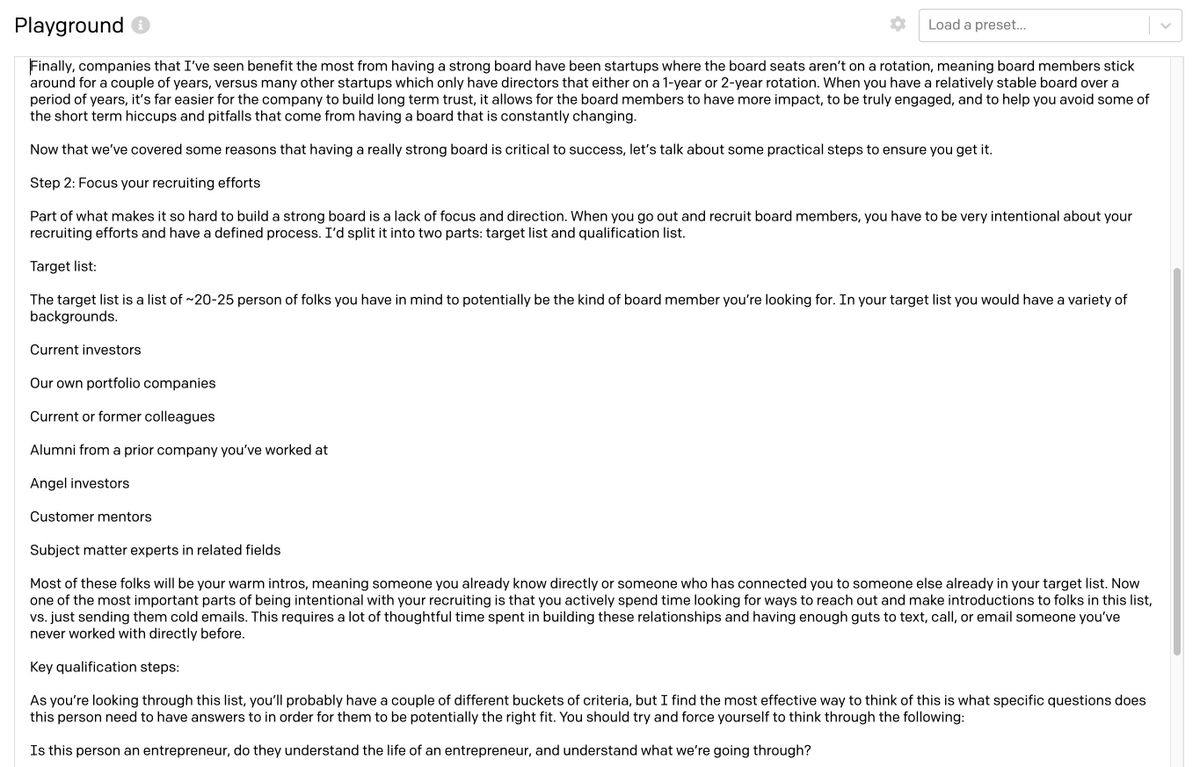

Затем Аспарухов обучил алгоритм на половине статьи «Как провести эффективное заседание правления» и получил текст о том, как набирать членов совета директоров.

В обоих примерах GPT-3 смогла сгенерировать не только последовательные и точные параграфы текста, но и сохранить стиль автора, сделав текст практически неотличимым от исходного.

Сооснователь и бывший технический директор блокчейн-стартапа OpenZeppelin Мануэль Араоз после получения доступа к GPT-3 за несколько часов сгенерировал:

- Короткую биографию и первую главу книги на испанском языке.

- Интервью с собой на испанском языке о книге, которую он «написал».

- Стихотворение в стиле поэта Хорхе Луис Борхеса, которое не смогли отличить от оригинала.

- Генератор рецептов из бессмысленных ингредиентов.

- Простое описание работы биткоина.

- Конвертер писем, который автоматически убирает агрессию.

Главным достижением Араоза стала статья «Почему GPT-3 может стать самым важным событием после биткойна», в которой рассказывает о своих экспериментах и признаёт, что алгоритм обладает «разрушительным потенциалом», сравнимым с блокчейном.

Но статью писал не он — весь текст сгенерирован GPT-3, который научился стилю автора. Для полноценной статьи хватило двух строк биографии, названия, тегов и общего посыла текста.

GPT-3 может писать стихи, поэмы, эссе, отвечать на вопросы и работать как чат-бот.

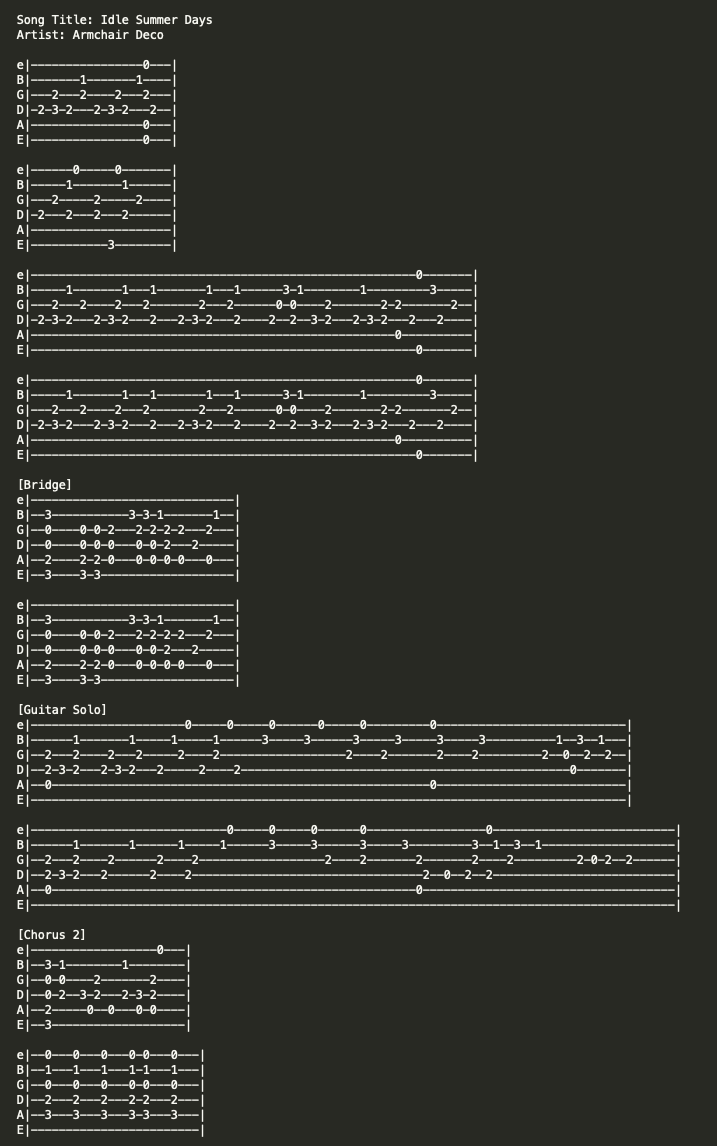

Песни и табулатуры

Ещё одна работа Араоза — полностью сгенерированная песня с аккордами и текстом.

Есть примеры создания полной табулатуры, сгенерированной по вымышленному названию песни и исполнителю.

«Поразительный, но перехайпленный»: за что критикуют GPT-3

Обозреватель Forbes Роб Тоуз считает, что GPT-3 — впечатляющее технологическое достижение, но со своими ограничениями, которые не позволяют говорить об искусственном интеллекте.

По его мнению, возможности GPT-3 действительно захватывают дух, так как позволяют не только писать обычные тексты, но и функциональный программный код и заниматься другими видами творчества, где используются текстовые и графические формулировки. А варианты использования ограничиваются только воображением.

Но по своей сути GPT-3 — лишь предсказатель текста. Пользователь даёт кусок текста в качестве входных данных, а модель генерирует своё предположение, каким должен быть следующий фрагмент текста.

При этом её предположение основано на всём, что было опубликовано людьми в интернете. У модели нет представления, что означают слова и символы, нет модели мира, и она не понимает, что она получает на входе и отдаёт на выходе.

GPT-3 не может мыслить абстрактно и у неё нет здравого смысла, отмечает обозреватель Forbes. Это не делает инструмент плохим, но он всё ещё ненадёжен и подвержен ошибкам, которые бы не совершил человек.

Это не «искусственный интеллект», но впечатляющее техническое достижение, способное создавать любой текст по любому запросу.

Его точку зрения поддерживает и глава инвестфирмы Founders Fund и ИТ-специалист Делиан Аспарухов. У машины нет способа проверить, что она выводит, а результат её работы выдаётся, как наиболее вероятный результат по входным данным, отмечает эксперт.

Результаты GPT-3 выдающиеся, но алгоритм всё ещё может потерять суть текста, забыть о его цели или перестать согласовывать между собой абзацы. А чтобы алгоритм провалил тест Тьюринга, его собеседнику достаточно начать задавать бессмысленные вопросы, например, «сколько глаз у камня?» или «сколько шнузлов вписывается в вамбгут?» — вместо того чтобы сказать «я не знаю», GPT-3 сгенерирует подходящий неподходящий текст.

Он хорош для создания последовательных цепочек мыслей, но для корректности текстов всё ещё нужен человек-редактор, заключает Аспарухов.

Предположения критиков подтверждает и глава OpenAI Сэм Альтман. По его словам, шум вокруг GPT-3 слишком силён: технология впечатляет, но имеет серьёзные недостатки и иногда совершает очень глупые ошибки: «ИИ собирается изменить мир, но GPT-3 — это всего лишь ранний проблеск. Впереди ещё многое предстоит выяснить».

Мне, как любителю рекурсий, больше всего понравилось его предсказание о выходе следующих версий

Тут нечему удивляться, он уже просчитал, что людям пиздец в 2023.

Комментарий недоступен

А как же алгоритм будет верстать шаблоны в фигме по словам заказчика "сделай красиво"

Комментарий недоступен

А вот интересно, сколько Есенин или Бродский или Байрон терабайт текстов прочитали, чтобы обучиться писать свои стишки?

Бля, мне одному кажется, что если Курт Кобейн к 30 годам уже все свои шедевры написал и застрелился, так и не прочитав 575ГБ текста, то это вот обучение, которое привело машину к тому, что она может срифмовать кеды и полукеды - тупик чуть более чем полностью?

Это классическая проблема нейросетей. Вам достаточно один раз получить удар током, чтобы не лезть в розетку. А нейросети примерно 1000.

Но ваш комментарий какой-то странный, вы пытаетесь унизить алгоритм? Вот это обучение.. тупик.. Это просто уровень развития технологий. Это не хорошо или плохо, это настоящая реальность. Почему вы от нее ожидаете больше?

Аналогично вашему комментарию можно было написать: "Какие же тупиковые эти автомобили, до сих пор чтобы доехать до работы надо стоять в пробке".

Не принимайте мой комментарий близко к сердцу. Я был вынужден заступиться за технологии :) Просто люди слишком много хотят от алгоритмов. Формируются завышенные ожидания, журналисты надувают очередной пузырь. Это все вредит индустрии.